Introducción a los Data Lakehouse

Los data lakehouse emergen como una revolucionaria arquitectura que combina lo mejor de dos mundos: los data lakes y los data warehouses. Este modelo híbrido integra la flexibilidad de los data lakes con la robustez analítica de los data warehouses, ofreciendo una solución integral para el almacenamiento y análisis de grandes volúmenes de datos en las empresas que generalmente se utilizan en los procesos de business intelligence.

Contexto del surgimiento de los Data Lakehouse

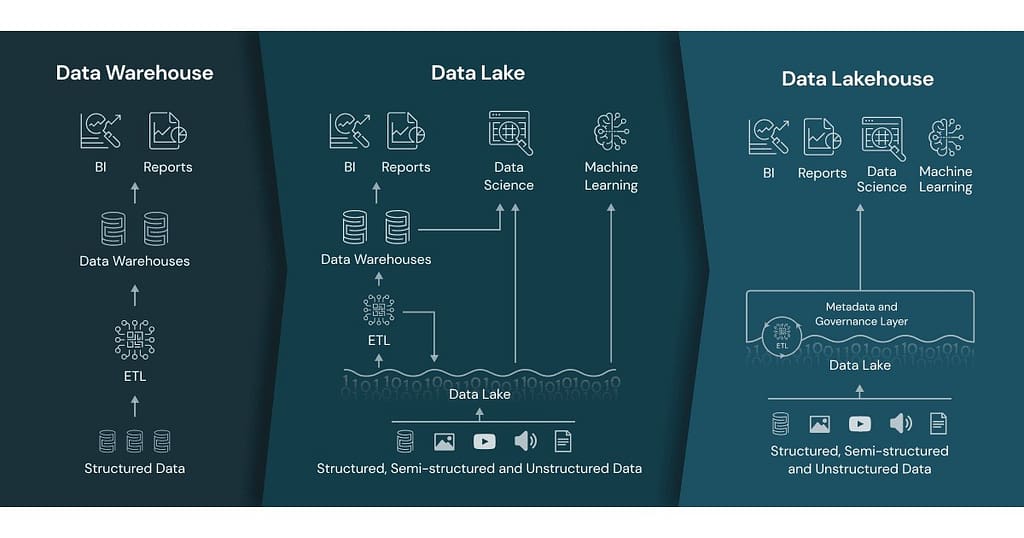

En los últimos años, el crecimiento exponencial de la cantidad de datos generados ha impulsado la necesidad de desarrollar nuevas arquitecturas que permitan su gestión y análisis de manera eficiente. Las arquitecturas tradicionales, como los data warehouses y data lakes, presentan limitaciones que dificultan el manejo óptimo de estos volúmenes de información.

- Data Warehouses: Tradicionalmente conocidos por su estructura rígida y optimización para el análisis de datos estructurados, permiten un procesamiento eficiente pero carecen de flexibilidad para datos no estructurados.

- Data Lakes: Diseñados para almacenar datos en su formato original, ofrecen flexibilidad y escalabilidad, pero presentan desafíos en cuanto a la gobernanza y calidad de datos.

Innovación y evolución hacia el Data Lakehouse

El concepto de data lakehouse nace como respuesta a la necesidad de combinar las ventajas de ambas arquitecturas sin sus respectivas desventajas. En esencia, un data lakehouse proporciona una plataforma unificada que permite:

- Almacenamiento Eficiente: Capacidad para almacenar tanto datos estructurados como no estructurados.

- Procesamiento Avanzado: Herramientas para análisis de datos avanzado utilizando big data, machine learning y business intelligence.

- Escalabilidad y Flexibilidad: Facilidad para adaptarse al volumen cambiante de datos empresariales.

Importancia en el entorno empresarial Actual

La implementación de un data lakehouse permite a las empresas maximizar el valor de sus datos al mejorar la eficiencia en su procesamiento y análisis, optimizando así la toma de decisiones. Esta arquitectura se alinea con la transformación digital, habilitando el uso de tecnologías emergentes como la inteligencia artificial (IA) y el aprendizaje automático (ML) para robustecer las estrategias de negocio.

Por lo tanto, los data lakehouse no solo representan una evolución tecnológica, sino también un cambio estratégico que sustenta el éxito empresarial en un entorno cada vez más competitivo y orientado por los datos.

Definición y evolución de los data lakehouse

¿Qué es un data lakehouse?

Un data lakehouse es una arquitectura moderna de gestión de datos que combina las mejores características de los data lakes y los data warehouses. Esta solución busca proporcionar almacenamiento optimizado para grandes volúmenes de datos no estructurados y estructurados, al mismo tiempo que ofrece capacidades de análisis avanzadas y acceso rápido mediante estructuras de datos optimizadas. El concepto principal detrás de un data lakehouse es proporcionar la flexibilidad de un data lake junto con la fiabilidad, las transacciones ACID, y la eficiencia en el procesamiento de datos que ofrece un data warehouse.

Evolución de la arquitectura de datos

La evolución hacia el data lakehouse responde a la creciente necesidad de las organizaciones de manejar grandes cantidades de datos de diversa índole de manera más eficiente y con mayor flexibilidad. Tradicionalmente, las empresas usaban data warehouses para el almacenamiento y análisis de datos estructurados, mientras que los data lakes se empleaban para datos no estructurados y semiestructurados. Sin embargo, esta bifurcación de tecnologías a menudo conducía a silos de datos, aumentaba la complejidad operativa y elevaba los costos.

Integración de tecnologías

Con el advenimiento de los data lakehouse, ha sido posible integrar diversas tecnologías y enfoques para superar estas limitaciones. Empresas emergentes y gigantes tecnológicos han desarrollado plataformas que facilitan esta integración, utilizando principalmente nuevas capas de procesamiento y gestión de datos. Estas capas permiten la ejecución de consultas SQL sobre datos de tipo diverso, sin necesidad de mover físicamente los datos entre almacenes. Además, las modernas herramientas de data lakehouse incluyen mecanismos para garantizar la calidad de los datos y asegurar transacciones confiables.

Ventajas estratégicas de la evolución

La evolución hacia un data lakehouse representa un avance estratégico al proporcionar una plataforma unificada que soporta tanto cargas de trabajo de inteligencia de negocios en tiempo real como casos de uso de machine learning. Esto permite a las organizaciones extraer valor del análisis de datos en una escala más amplia y a un costo menor, eliminando la necesidad de duplicados de datos y reduciendo el tiempo de inactividad al consolidar estrechamente la gestión del ciclo de vida de los datos.

Al adoptar un enfoque de data lakehouse, las empresas están mejor equipadas para responder a las necesidades de análisis de datos dinámicas y complejas del entorno empresarial actual.

Componentes clave de un data lakehouse

Un data lakehouse es una arquitectura que combina las características de un data lake y un data warehouse, reuniendo lo mejor de ambos mundos para ofrecer una solución integral de gestión de datos. A continuación, exploraremos los componentes fundamentales que conforman un data lakehouse.

Almacenamiento económico y escalable

Uno de los componentes esenciales de un data lakehouse es su capacidad de almacenamiento. Utiliza almacenamiento en la nube de bajo costo para mantener grandes volúmenes de datos. Este componente permite escalar de manera eficiente, ajustándose a las necesidades de volumen de datos fluctuante, sin incurrir en altos costos adicionales.

Capas de procesamiento unificado

En un data lakehouse, existen capas de procesamiento que integran tanto el procesamiento en tiempo real como el procesamiento por lotes. Esta integración garantiza que los usuarios puedan acceder y analizar datos en tiempo real o mediante informes predefinidos, lo que permite una toma de decisiones más rápida y precisa.

Motor de consultas SQL

El motor de consultas SQL es crucial en un data lakehouse, ya que proporciona un lenguaje familiar para interactuar con los datos. Facilita a los analistas y científicos de datos ejecutar consultas complejas y obtener información valiosa sin necesidad de aprender nuevas sintaxis de lenguaje.

Gestión de metadatos

Un robusto sistema de gestión de metadatos es indispensable en un data lakehouse. Este componente organiza y documenta la información sobre los datos almacenados, facilitando la localización, acceso y utilización de los datos, lo que mejora la eficiencia en la generación de informes y análisis.

Catálogo de datos

El catálogo de datos forma parte del sistema de gestión de metadatos, proporcionando una vista completa de los activos de datos disponibles. Ayuda a los usuarios a encontrar rápidamente los datos relevantes y comprender su linaje, calidad y accesibilidad.

Seguridad y gobernanza de datos

En un data lakehouse, la seguridad y gobernanza de datos son cruciales para proteger la integridad de la información. Esto incluye la implementación de políticas de acceso y control riguroso para garantizar que solo los usuarios autorizados puedan acceder a datos sensibles.

Auditoría y cumplimiento

Las funcionalidades de auditoría y cumplimiento aseguran que las operaciones de datos cumplan con las regulaciones y estándares de la industria. Los regímenes de auditoría robustos permiten un seguimiento detallado del uso de datos y actividades dentro del lakehouse.

Interoperabilidad e integración de datos

La interoperabilidad de un data lakehouse con otras aplicaciones y herramientas es esencial para una integración fluida de datos. Esta característica permite a las empresas combinar datos de diversas fuentes para proporcionar una vista holística y detallada para el análisis.

Este conjunto de componentes clave asegura que un data lakehouse brinde la flexibilidad, escalabilidad y accesibilidad que las organizaciones necesitan para manejar y explotar datos en el entorno dinámico actual.

Diferencias entre Data Lake, Data Warehouse y Data Lakehouse

Data Lake

Los Data Lakes son sistemas de almacenamiento que permiten a las organizaciones conservar grandes volúmenes de datos en su forma original, es decir, en bruto. Estos sistemas son ideales para datos no estructurados y semi-estructurados, como archivos de texto, imágenes y videos. La principal ventaja de los Data Lakes es su capacidad de escalar de manera económica y flexible, admitiendo cualquier tipo de dato sin necesidad de transformar o procesar de inmediato. Se utilizan comúnmente para análisis avanzado y machine learning, donde es esencial tener acceso a conjuntos de datos variados y detallados.

Data Warehouse

Por otro lado, los Data Warehouses son almacenes de datos optimizados para el análisis de alta velocidad de datos estructurados. A diferencia de los Data Lakes, los datos en un Data Warehouse son transformados y organizados para cumplir con propósitos analíticos específicos. Son conocidos por su capacidad de ofrecer consultas rápidas y de rendimiento consistente, lo que los hace adecuados para informes empresariales y procesamiento analítico online (OLAP). Los Data Warehouses son una opción comprobada para las organizaciones que necesitan acceder a datos consolidados y limpios para tomar decisiones estratégicas.

Data Lakehouse

El Data Lakehouse combina las mejores características de los Data Lakes y los Data Warehouses en una única plataforma integrada. Ofrece la flexibilidad de un Data Lake en cuanto a la ingesta de datos en bruto y la economía de escalabilidad, al mismo tiempo que proporciona las capacidades analíticas y el rendimiento de consulta de un Data Warehouse. Un Data Lakehouse permite a las organizaciones ejecutar análisis complejos y de inteligencia de negocios sin necesidad de mover los datos de un lado a otro entre diferentes sistemas, mejorando así la eficiencia operativa y reduciendo el costo total de propiedad.

Comparaciones Clave

- Almacenamiento de Datos: Los Data Lakes son más adecuados para datos no estructurados, mientras que los Data Warehouses se centran en datos estructurados. El Data Lakehouse admite ambos tipos de datos, proporcionando una solución versátil y unificada.

- Procesamiento de Datos: Los Data Lakes almacenan datos en su forma original y suelen ser utilizados para análisis exploratorios. Los Data Warehouses procesan y organizan los datos antes de almacenarlos, facilitando consultas rápidas. El Data Lakehouse mantiene la capacidad de realizar análisis de datos estructurados y no estructurados.

- Escalabilidad y Costo: Los Data Lakes ofrecen una solución de bajo costo y alta escalabilidad para almacenar grandes volúmenes de datos. Los Data Warehouses implican un costo más alto por su capacidad de procesamiento rápido. El Data Lakehouse busca balancear estos aspectos, ofreciendo una solución económica con capacidad de procesamiento optimizada.

- Aplicaciones y Casos de Uso: Los Data Lakes son ideales para tareas de machine learning y big data. Los Data Warehouses están orientados a análisis empresariales y reports. El Data Lakehouse permite a las organizaciones aprovechar al máximo ambas aplicaciones, con una infraestructura simplificada y cohesiva.

Las diferencias entre estos enfoques reflejan sus respectivas fortalezas y limitaciones, permitiendo a las organizaciones elegir la arquitectura que mejor se adapte a sus necesidades específicas en cuanto a gestión y análisis de datos.

Beneficios de implementar un data lakehouse

Integración y Accesibilidad de Datos

Una de las principales ventajas de un data lakehouse es la capacidad de integrar datos estructurados y no estructurados en una única plataforma. Esta convergencia permite acceder y analizar datos desde diversas fuentes sin necesidad de trasladarlos a entornos separados o ejecutar conversiones complejas, mejorando así la accesibilidad y reduciendo el tiempo de preparación de datos.

Eficiencia en Costos

Implementar un data lakehouse puede resultar más económico que mantener infraestructuras separadas para data lakes y data warehouses. Al unificar ambas arquitecturas, se reducen los costos de almacenamiento y se optimizan los recursos, permitiendo escalar sin necesidad de grandes inversiones iniciales en hardware o software.

Rendimiento Mejorado

Los data lakehouse ofrecen un rendimiento superior al permitir el procesamiento en paralelo y el acceso directo a grandes volúmenes de datos. Esto habilita análisis más rápidos y eficientes, beneficiando a las empresas que requieren tomar decisiones en tiempo real basadas en datos frescos.

Flexibilidad y Escalabilidad

Gracias a su diseño moderno, los data lakehouse proporcionan una gran flexibilidad para adaptarse a diferentes cargas de trabajo y volúmenes de datos. Esta capacidad de escalar de manera horizontal es vital para empresas que buscan crecer sin preocuparse por limitaciones tecnológicas.

Capacidad Analítica Avanzada

Con un data lakehouse, las empresas pueden emplear técnicas avanzadas de análisis, incluyendo machine learning, directamente sobre sus datos almacenados. Esta integración facilita la extracción de insights valiosos y la identificación de patrones complejos que pueden ser aprovechados para mejorar decisiones estratégicas.

Gobernanza y Seguridad de Datos

A diferencia de los data lakes tradicionales, un data lakehouse mejora las capacidades de gobernanza de datos al ofrecer características robustas de seguridad y control de acceso. Esto asegura que los datos sean utilizados de manera ética y conforme a regulaciones vigentes, protegiendo la confidencialidad y privacidad de la información sensible.

Desafíos y consideraciones al adoptar un data lakehouse

Integración con sistemas existentes

La adopción de un data lakehouse implica un entorno integrado donde coexisten un data lake y un data warehouse. Sin embargo, esto puede representar un desafío al intentar alinear esta nueva arquitectura con sistemas de análisis y gestión de datos existentes. Es esencial evaluar la compatibilidad del data lakehouse con las infraestructuras de TI actuales para asegurar una integración fluida y evitar la duplicación de esfuerzos o datos.

Manejo de grandes volúmenes de datos

Un data lakehouse está diseñado para gestionar grandes conjuntos de datos. No obstante, el crecimiento exponencial de datos puede generar desafíos adicionales, como la gestión del almacenamiento y el rendimiento. Las organizaciones deben planificar y optimizar adecuadamente los recursos de infraestructura para manejar eficientemente estos volúmenes de datos, garantizando que el acceso a los datos sea rápido y eficiente.

Seguridad y cumplimiento

La seguridad de los datos y el cumplimiento normativo son aspectos críticos al adoptar un data lakehouse. Los datos deben estar adecuadamente protegidos contra accesos no autorizados y potenciales brechas de seguridad. Además, dado el manejo de grandes volúmenes de datos que pueden contener información confidencial, es crucial que las empresas cumplan con normativas como GDPR, HIPAA, y otras regulaciones de protección de datos aplicables a su sector.

Gobernanza de datos

Implementar un marco sólido de gobernanza de datos es esencial para asegurar que los datos en un data lakehouse sean precisos, confiables y estén bien organizados. La ausencia de políticas claras de gobernanza puede llevar a inconsistencias, obsolescencia de datos y, en última instancia, afectar la calidad del análisis de datos. Es vital establecer roles y responsabilidades, así como procesos claros para la gestión de metadatos y la calidad de los datos.

Costo de implementación

El despliegue de un data lakehouse puede representar una inversión significativa en términos de software, hardware y formación del personal. Las empresas deben realizar un análisis de costo-beneficio detallado para entender si los beneficios potenciales superan los costos asociados. También es importante considerar el costo de mantenimiento a largo plazo y las posibles actualizaciones futuras.

Selección de la tecnología adecuada

Con diversas opciones de tecnología para construir un data lakehouse, elegir la plataforma adecuada puede ser desafiante. Las organizaciones deben considerar factores como las capacidades técnicas de la solución, la facilidad de uso, el soporte al cliente, y la capacidad de integración con otras herramientas analíticas. La escalabilidad y flexibilidad de la solución también son cruciales para adaptarse a las necesidades cambiantes del negocio.

Analizar estos desafíos y consideraciones permitirá a las empresas tomar decisiones informadas y maximizar el valor que un data lakehouse puede aportar a su gestión de datos.

Casos de uso y aplicaciones prácticas de los Data Lakehouse

Los data lakehouse representan una innovadora aproximación que fusiona las capacidades analíticas de un data warehouse con la flexibilidad y el bajo costo de un data lake, permitiendo a las empresas gestionar tanto datos estructurados como no estructurados en una sola plataforma integrada. A continuación, exploraremos algunos casos de uso y aplicaciones prácticas donde los data lakehouse han demostrado ser transformadores.

Análisis avanzado en el sector financiero

En el ámbito financiero, los data lakehouse han permitido a las instituciones realizar análisis avanzados en tiempo real. Por ejemplo, los bancos pueden utilizar esta tecnología para detectar fraudes mediante el análisis de transacciones en tiempo real, combinando datos históricos y actuales. Además, facilita la creación de modelos de machine learning para prever el comportamiento del cliente y mejorar las campañas de marketing.

Mejoras en la atención médica

El sector salud ha adoptado los data lakehouse para mejorar el tratamiento de pacientes y la investigación clínica. Al almacenar grandes volúmenes de datos provenientes de diversas fuentes, como registros médicos electrónicos y dispositivos IoT, las organizaciones de salud pueden realizar análisis predictivos que optimizan los planes de tratamiento personalizados y gestionan mejor los recursos clínicos.

Optimización de la cadena de suministro en manufactura

En la industria manufacturera, los data lakehouse permiten la integración de datos provenientes de múltiples fuentes, como sensores de maquinaria, sistemas ERP y cadenas de suministro, para identificar ineficiencias y prever posibles interrupciones. Esto facilita la optimización de los procesos de producción y reduce los costos operativos.

Experiencia personalizada en el sector retail

Las empresas minoristas pueden beneficiarse de los data lakehouse para analizar datos de clientes obtenidos a través de múltiples canales, como compras en línea, en tienda física y redes sociales. Esto les permite ofrecer recomendaciones de productos personalizadas, gestionar inventarios de manera eficiente y diseñar campañas de marketing más efectivas.

Logística y transporte

En el sector de la logística, los data lakehouse aportan una gran ventaja al permitir el análisis en tiempo real de datos de rutas, flotas y demanda. Las empresas pueden optimizar las rutas de entrega, reducir tiempos de inactividad y mejorar la satisfacción del cliente a través de un seguimiento más preciso de los envíos.

Innovación en la industria del entretenimiento

Las plataformas de streaming y medios digitales utilizan data lakehouse para mejorar la experiencia del usuario mediante la personalización de contenido y la optimización de recomendaciones basadas en el comportamiento, preferencias y patrones de visualización de sus usuarios, proporcionando así una experiencia más atractiva y personalizada.

Cada uno de estos ejemplos destaca cómo los data lakehouse no solo simplifican la gestión de grandes volúmenes de datos, sino que también ofrecen ventajas competitivas a las organizaciones que buscan insights accionables en sus operaciones diarias.

Conclusiones

Un data lakehouse es una solución moderna y eficiente que combina lo mejor de los data lakes y data warehouses, permitiendo a las empresas gestionar y analizar grandes volúmenes de datos de manera flexible y escalable. Al integrar datos estructurados y no estructurados en un solo entorno, las organizaciones pueden acceder a insights en tiempo real, optimizar la toma de decisiones y reducir costos operativos. Esta arquitectura de datos es ideal para empresas que buscan mantenerse competitivas en un entorno impulsado por datos, mejorando la eficiencia en sus procesos y descubriendo nuevas oportunidades de negocio.

¿Listo para transformar la gestión de tus datos? Contacta con nosotros y descubre cómo podemos implementar una solución de data lakehouse adaptada a las necesidades específicas de tu empresa. ¡Hablemos de tu proyecto hoy mismo!